A inteligência artificial está amadurecendo, passando de protótipos de prova de conceito para a prática clínica diária. Em nenhum lugar essa evolução é mais visível do que na radiologia com IA, onde algoritmos interpretam imagens de raios-X, tomografia computadorizada e ressonância magnética ao lado, e às vezes à frente, dos leitores humanos. No entanto, à medida que o desempenho técnico melhora, surgem novas questões sobre a responsabilidade quando a máquina e o médico discordam. Um novo ensaio randomizado na NEJM AI adiciona peso empírico a essas preocupações e fornece um trampolim para uma reflexão estratégica sobre como inovadores como a AZmed devem navegar pelo cenário médico-legal em constante mudança.¹

O que as novas evidências mostram

No estudo realizado por Bernstein et al. (NEJM AI, Vol. 2, No. 6, 22 de maio de 2025), 1.334 adultos norte-americanos leram vinhetas nas quais um radiologista não detectou um sangramento cerebral ou um câncer de pulmão. Cinco braços experimentais variaram se um algoritmo também foi usado e se sua saída correspondia à do radiologista. Quando a IA em radiologia sinalizou a anormalidade que o humano não detectou (“IA discorda”), 72,9% dos jurados julgaram o radiologista responsável pelo sangramento cerebral, contra 50,0% quando o sistema também não detectou (“IA concorda”). O padrão se manteve para o câncer (78,7% contra 63,5%). É importante ressaltar que fornecer métricas de erro suavizou os julgamentos: divulgar uma taxa de descoberta falsa de 50% reduziu a responsabilidade por casos de hemorragia cerebral de 72,9% para 48,8%.

Conclusão principal: a discordância entre humanos e algoritmos amplifica a percepção de negligência, mas dados transparentes sobre o desempenho podem restaurar o equilíbrio.

Implicações para a prática clínica

Essas descobertas repercutem muito além do tribunal. Elas sugerem que a IA para radiologia introduz um “efeito de segundo observador”: uma vez que um algoritmo está em ação, os médicos são avaliados em relação a um padrão tecnológico mais elevado. Radiologistas que silenciosamente ignoram uma máquina podem parecer imprudentes, mesmo quando seu julgamento clínico está correto. Por outro lado, a confiança cega no software traz seus próprios riscos. O caminho ideal é o raciocínio documentado, registrando por que um achado de imagem foi aceito ou rejeitado e a divulgação sistemática da precisão algorítmica.

Do ponto de vista da gestão de riscos, as organizações de saúde devem:

- Exija campos de justificativa estruturados nos sistemas de relatórios sempre que o radiologista ignorar a recomendação da IA.

- Registre a confiança do algoritmo e as taxas de erro conhecidas no sistema de arquivamento e comunicação de imagens (PACS) para que o contexto acompanhe a imagem em toda a instituição.

- Forneça aos jurados e pacientes informações calibradas sobre as incertezas inerentes à interpretação humana e mecânica, refletindo os dados “FDR/FOR” que reduziram a responsabilidade no julgamento.

Um cenário regulatório em rápida evolução

A nuance jurídica surge em meio a uma atividade regulatória explosiva. Em fevereiro de 2025, a FDA dos EUA havia aprovado 758 produtos de IA/ML voltados para radiologia, de longe a maior parcela de qualquer especialidade.² O projeto de orientação da agência de janeiro de 2025 sobre “Funções de software de dispositivos habilitados para IA” sinaliza um escrutínio mais rigoroso do monitoramento de desempenho pós-comercialização e enfatiza a necessidade de supervisão humana.³

Enquanto isso, os modelos generativos estão conquistando um nicho diferente. Grandes modelos de linguagem agora compõem impressões preliminares e instruções para pacientes, reduzindo o tempo de documentação, mas evitando em grande parte as alegações de diagnóstico e, portanto, os encargos regulatórios mais pesados.⁴ Para os inovadores, a mensagem é clara: o padrão para algoritmos de diagnóstico autônomos está aumentando, enquanto ferramentas de apoio, não diagnósticas, desfrutam de um caminho mais curto para a adoção.

O ponto de vista da AZmed

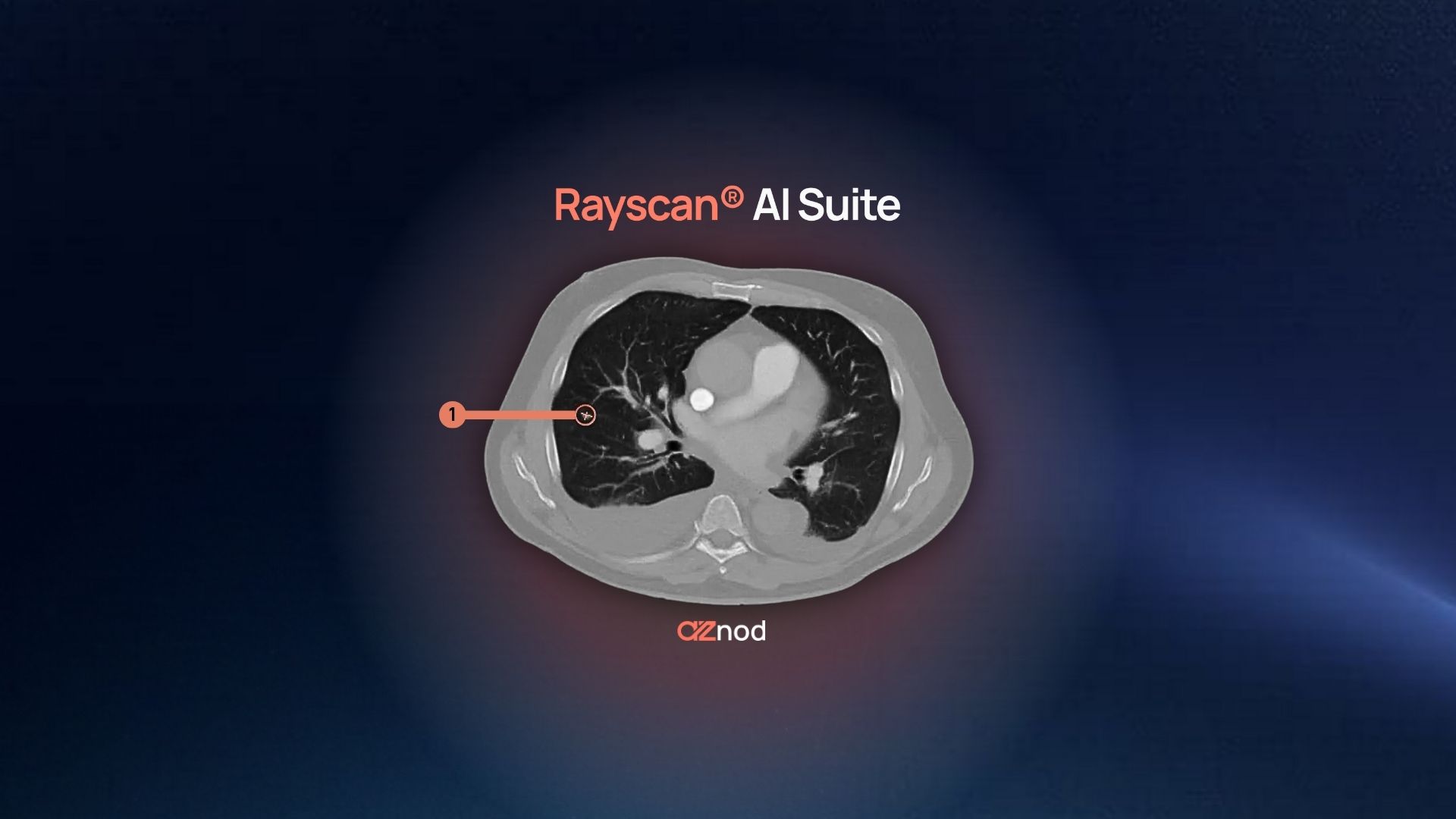

O Rayvolve®, o principal produto de IA da empresa, processa dezenas de milhares de raios-X todos os dias, classificando automaticamente os exames ao inserir caixas delimitadoras em torno de achados suspeitos e sinalizando casos urgentes para análise imediata pelo radiologista.

Do ponto de vista da AZmed, os novos dados de IA do NEJM destacam duas prioridades:

- Transparência radical. Além de publicar números precisos, a AZmed deve incorporar pontuações de confiança em tempo real específicas para cada caso e destacar os modos de falha conhecidos (por exemplo, sobreposição com gessos ou centros de ossificação pediátrica atípicos).

- Diálogo humano-máquina. A criação de um módulo leve de "motivo de rejeição" permitirá que os usuários anotem o motivo pelo qual desconsideraram um alerta, gerando migalhas de pão forenses que reduzem o risco de litígios e alimentam ciclos contínuos de aprendizado.

Recomendações estratégicas

- Codifique a responsabilidade: adote um protocolo de decisão compartilhada em que o radiologista, o algoritmo e, quando apropriado, a equipe multidisciplinar assinem digitalmente.

- Educar as partes interessadas: Use grandes rodadas, simulações de júri e infográficos voltados para os pacientes para desmistificar as estatísticas algorítmicas. A queda de 24 pontos na percepção de responsabilidade quando os dados FOR foram mostrados (cenário de hemorragia cerebral) é um argumento convincente para tal divulgação.

- Monitoramento na produção: combine cada modelo de IA com uma “auditoria paralela” que sinalize desvios na distribuição; os reguladores esperam cada vez mais essa vigilância contínua.³

- Utilize a IA generativa de forma responsável: Implante grandes modelos de linguagem para a elaboração de relatórios e comunicação, mas proteja-os de alegações de diagnóstico não supervisionadas para permanecer dentro das zonas de conforto regulatórias atuais.⁴

Conclusão

O futuro da radiologia com IA não se resume apenas a algoritmos mais inteligentes, mas também a uma governança mais inteligente. O julgamento de Bernstein deixa claro que a percepção pública e, por extensão, a opinião do júri, dependem da harmonia entre a expertise humana e a inteligência artificial. Para a AZmed, a missão é dupla: continuar expandindo os limites técnicos e, ao mesmo tempo, incorporar recursos de design que tornem a responsabilização explícita e a compreensão intuitiva. Faça isso bem, e a IA em radiologia não apenas acelerará os diagnósticos, mas também elevará a confiança em todo o espectro de cuidados.

Leia o estudo completo aqui.

References

- https://ai.nejm.org/doi/10.1056/AIoa2400785

- https://www.fda.gov/medical-devices/software-medical-device-samd/artificial-intelligence-and-machine-learning-aiml-enabled-medical-devices

- https://www.fda.gov/media/184856/download

- https://www.businessinsider.com/radiology-embraces-generative-ai-to-streamline-productivity-2025-6